2016.12.29

舘 暲(東京大学) テレイグジスタンスの提唱者が語る“未来の世界”のつくり方

〜社会の在り方を変えるHAPTICS〜

舘 暲(たち・すすむ)

東京大学名誉教授、工学博士。日本バーチャルリアリティ学会初代会長。専門はロボット学とバーチャルリアリティ学。1980年、世界で初めてテレイグジスタンスの概念を提唱、以来その実現のための研究を行う。テレイグジスタンスのほかにも、盲導犬ロボット、再帰性投影技術、触原色、裸眼立体VRなどの独創的な研究で世界に知られる。IEEE Virtual Reality Career Award、通商産業大臣賞、文部科学大臣賞をはじめ各賞を受賞。また、1993年には、国際学生対抗バーチャルリアリティコンテスト(IVRC)を創始した。『バーチャルリアリティー入門』『ロボット入門 つくる哲学・つかう知恵』『Telexistence』など、著書多数。

舘 暲さんは、世界のVRの第一人者として、離れた場所に存在する分身ロボット(アバター)を自分の新たな身体とするテクノロジーである「テレイグジスタンス」を提唱。視覚・聴覚をメインとした“映像”としてのVRだけでなく、触覚に基づく「身体性メディア」をキーに、新しい産業の創出を目指している。「HAPTICエディター」「遠隔就労」「触覚伝送モジュール」など刺激的すぎるワードが飛び出した、HAPTICSがもたらす時間も距離も超える“未来の世界”についてのお話。子どものころに夢見たユートピアは、もうすぐそこまで来ているのかもしれません。

ご自身の研究分野におけるHAPTICS(触覚学)と、

その位置づけについて教えてください。

バーチャルリアリティ(VR)とテレイグジスタンス(Telexistence)を研究しています。コンピューターでつくったバーチャルな空間に自分が居るように感じるのがVR。遠隔地など自分がいま居る場所と別の場所(実世界)にあるアバターを繋ぐのがテレイグジスタンスです。実は両者にはあまり境がなく、VRは“コンピューターのつくった世界にテレイグジスタンスしている”と考えると、同じことなります。

我々は、テレイグジスタンスやVRを総称して「身体性メディア」と呼んでます。「身体性メディア」では、アバター(バーチャルヒューマンや分身ロボット)という、別世界のなかでの新しい自分自身の身体を持ちます。その身体を使って、その世界を見て聞いて触って、話しかけて、動き回り、コミュニケーションし、アクションできる。つまり、自分自身が、アバターの身体を使って、その世界に存在できるのです。ですから視覚や聴覚などの感覚は勿論重要ではあるものの、自分の身体に深く関わる「触覚」が重要になってきます。もちろん「触覚」とひと口に言っても皮膚感覚のことだけではありません。身体を動かすことによって生じる運動感覚を含む「HAPTICS」が非常に大事なのです。VRでも現実でも、世界とインタラクションするのは常に「触覚」なのです。

−東京大学 舘研究室

ではなぜ、実世界でも極めて重要度の高い「触覚」が置き去りになってしまったのか? それには「触覚」を意識的に分析してこなかった歴史があります。視覚を例にとると、色などはRGBで分解できて、伝送して他者に共有することができる。それによって印刷やテレビ、映画など、さまざまなメディアがつくられて、標準的に使われるようになった。触覚の場合もいろいろな装置はつくられているけれど、それらはすべてアドホック(特定の目的を持った)なものであって、視覚のようにすべての色がRGBの混合比によって表現できるような普遍的なやり方になっていなかったんですね。

そこで私は「触原色(haptic primary colors)」という考え方を提唱しました。皮膚感覚を例にとると、人間が感じるガサガサとかツルツルという触感は、実は皮膚の下の触覚受容器で受けた信号に基づいて、人が頭の中で作り出しているわけです。その受容器の特性をよく見てみると、受容器が反応しているのは、実は基本的には、「振動」「力」「温度」の3つだということが分かりました。そうであれば、それらを計測して伝達して再現すれば、同じ感覚を生じさせることができるはずです。ただ触覚の場合には、視覚で言うところのRGBよりは少し難しくて、音に近いところがあり時間変化が関わってきます。しかも、人の身体と対象との接触状態の変化に応じて「力」と「振動」と「温度」の時間変化が発生するのです。

TELESAR V (テレサ・ファイブ)という最新のテレイグジスタンスシステムでは、この触原色原理により、テレサの指で物体を触り、その時に生じる、力と温度と振動を計測して伝送し、人間の指先につけた触覚ディスプレイで力と温度と振動を再現して、布などの細やかな触感を伝達することができました。2012年のことです。

−東京大学 舘研究室

触覚においては、現在どのような研究を行っているのですか?

最近では科学技術振興機構(JST)の「ACCEL」というイノベーション志向の研究開発プロジェクトである「身体性メディア研究プロジェクト」の研究代表者を務めています。いま「Google Glass」や「HoloLens」など、AR(拡張現実)やMR(ミックストリアリティ/複合現実)などVRと現実をつなぐ技術の実用化が進んでいます。我々は、それをさらにテレイグジスタンスにより進展させることにより、人間を空間と時間の制約から解き放つことを考えています。その好例として後述するテレイグジスタンスを用いた遠隔就労があります。そのような応用には、グローブ型デバイスなど、ウェアラブル触覚デバイスの開発が急務なのですが、それらは、HMD(頭部搭載型ディスプレイ)などの視聴覚デバイスに比べると30年ほど前からほとんど進歩していないのです。そこには、さきほど述べた「触覚の問題」があって、まずはそれを解決しないと、先には進まないわけです。

「身体性メディア」のプロジェクトの目的も、まずはそこにあります。「触原色」の原理を基にして、小型・一体型の触覚伝送モジュールを開発し、それをウエアラブルデバイスに展開します。それとともに、放送やエンターテインメント分野での実用化を目指す「身体性コンテンツ・プラットフォーム」と、ロボットを用いた遠隔就労という新しい可能性を示す「身体性テレイグジスタンス・プラットフォーム」を構成して産業分野や一般のユーザーへ広く提供することを考えています。ただ新しい分野に対しては、みんななかなか保守的なところがあるので、実際にモノをつくって「これはどうやって使うもので、何が改善されるのか」を見てもらう必要がある。ともかく体験しないと腑に落ちないのです。体験すると、目から鱗が落ちたといってくれる人が大半です。そのために、日本科学未来館の「Cyber Living Lab」を拠点に、コンソーシアムをつくるなどの取り組みを行っています。

また、新産業に展開するため、触覚伝送モジュール開発キット(SDK)を公開するのと並行して、ウェアラブルの触覚ディスプレイやグローブ、ウェアなどを提供するベンチャービジネスの創出も目指しています。この分野の適用範囲はとても広いのですが、まずは放送分野やスポーツ、エンターテインメント分野など。次いで介護、医療、ヘルスケアへの展開を考えています。遠隔就労などは、私たちの暮らしそのものを変革する可能性を秘めた、それらの最終的な青写真といえます。

ご自身の研究とHAPTICSがもたらす未来の社会、産業、生活の可能性とは?

−ACCEL「身体性メディア」プロジェクト

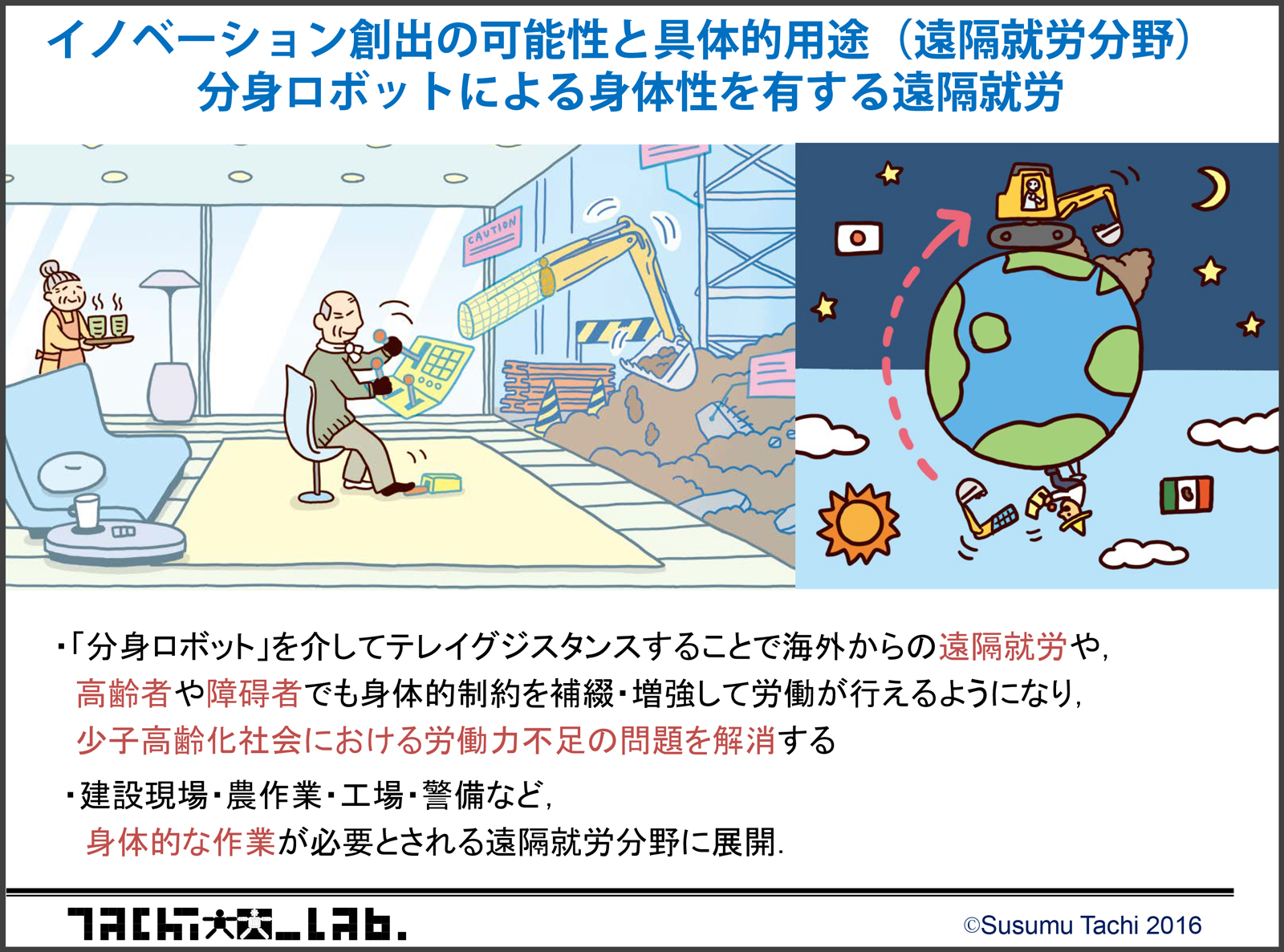

これから超少子高齢化時代が来る、と言われていますよね。大都市への一極集中とか、高齢者の増加。そうなってくると、子育てと労働の両立ができなくなって、さらに少子化が進む。通勤時間をとられて、自分の時間がまったく持てなくなる……。それらを根本的に変えるのが、テレイグジスタンスだと考えています。

テレイグジスタンスなら実際に身体を移動しなくても、身体機能のみ移動でき、義体による身体機能の拡張も可能です。身近な例で言えば、離れた職場に自分のアバターを置いておいて仕事をするなど、自宅で育児や介護を行わなくてはならない人でも、自宅もしくは近所のオペレーションルームみたいなところで、仕事ができるようになんです。

高齢者でも経験を活かした仕事ができるようになります。目が見えにくくなっていても、ロボットの身体を借りれば見えやすくなる。仮に手が震えていても、ロボットの身体ならすっと動く。障害がある人でも、障害にあわせたインターフェイスによって残存機能を使ってコントロールが可能になる。「新しい自分の身体を持つ」そんな夢のようなことが、テレイグジスタンスで可能になるのです。

それから日本で働きたい外国人が、わざわざ来日せずとも日本の仕事に就くことも可能です。自分の街に日本の就労用オペレーションルームがあって、そこに行ってロボットスーツに乗り込んで日本と繋ぐんです。来る必要がなくなれば、移民問題も起きない。また各国の時差があるので、工場は24時間稼働しても、みんなまともな時間に働くことができる。夜勤なんて強要しなくていい。反対に、日本のものづくりの技術を外国に簡単に教えに行くこともできる。これらは知的労働でも同じです。

全自動ロボットでできる分野もあるでしょうが、そういうものは今の時点でもすでに機械化されています。製造業でもすべてのものを、そう簡単には自動化できないから、結局人がやる必要のある仕事が残っている。しかし、テレイグジスタンス使えば、一部を自動化し一部を人がやる、ということがもっとシームレスにできりようになります。これにより、すべてをロボットでやるよりずっと柔軟な人間的な作業が代替出来るでしょうし、人の働く機会を奪ったりもしない。移動もしなくて済むので無駄なエネルギーを使わず、地球にも人にも優しい。社会や、ものの考え方自体が変わる、と思っています。

研究内容を社会実装していくうえでのデザインについて

どう捉えていますか?

デザインというのはとくに最近、かなり広い意味で使われていますよね。いわゆる意匠という意味だけじゃなくて、アイディアや考え方を形にするのがデザイン。自分の頭のなかにある抽象的なモノとか考えとか、そういったことを具象、具体的なモノに落としていくことがデザインです。その過程においても、VRは非常に使いやすい。どういうことかと言うと、頭のなかにあるものを実際のモノにする過程として、VR世界の中で具象化します。デザインツールとしてのVRです。それを手に取って見ることができたり、肌触りも感じられる。第三者による評価も可能ですし、それに基づく変更もインタラクティブに行えます。

現在のグラフィックスアプリケーションの3Dグラフィックスエディターの機能に加えて、肌触りなども「HAPTICエディター」とかのツールを使って、3DCGに加えていくことができる。つまり、自分のつくったモノに、色や艶といった質感をCGで入れるわけですが、さらに実際にそれを触った感じや重さなんかも「HAPTICエディター」に入れる。この面はもう少しザラザラさせようとか、もっと重厚感を持たせようとか、指定するんです。建築物なら、実際にVR空間に建築物をつくって、ウォークスルーしたり、家具を配置をみたり。またエンターテインメントの分野では、小説を書いたり、映画をつくったりすることの代わりに、VR作品を発表するなんて時代も、もうすぐそこまで来ていると思います。

ちなみに「HAPTICエディター」をつくるには、やはり先ほどの触原色が大切ですね。RGBを指定するように「力」のパターン、「振動」のパターン、「温度」のパターンを設定していく。もう一方で「ツルツル」とか「ザラザラ」などのオノマトペを指定する方法もあります。オノマトペによる指定は、言葉による色の指定に似ています。色では、あさぎ色とか橙色とか、主観的な感覚を言葉に置き換えているわけですが、それを触覚で行うのが触覚オノマトペです。あとは身体の動きに対するパターンの変形アルゴリズムが必要です。そういうことを解決していくと、「HAPTICエディター」をつくることが出来ると思います。

もっとも素敵なHAPTICSだと思う

世の中のモノゴト(事例)とは?

現在はもう市販されていませんが、私が学生のころの1960年代後半から70年代初頭に実験室でよく使っていた「Nikon F」というカメラですかね。これはNikon初の一眼レフで、フィルムの巻き取りやシャッターを押すときの触感、フォーカスを手動で合わせる感じ。暗室で触感を頼りにフィルムを取り出すんですが、その感覚もよかったですね。Nikon Fは、そのほとんど全部がバラバラになるまで簡単に分解したり組み立てたりできます。今でも自分の手に、その触感が残っています。もしいま目の前に置いてあったら、手にとって触りたい衝動にかられるでしょう。堅牢な精密機械そのもののカメラで“スペックの塊”にもかかわらず、手触りは素晴らしかった。まさにHAPTICSの権現だと思います。

TEXT BY HIROYUKI TOYODA/EDITED by MASARU YOKOTA(Camp)

PHOTOGRAPH BY HAJIME KATO